LoRA (Low-Rank Adaptation) và QLoRA (Quantized LoRA) là hai kỹ thuật được xếp vào dạng parameter-efficient fine-tuning (PEFT) – giúp tinh chỉnh mô hình ngôn ngữ lớn (LLM) một cách tiết kiệm tài nguyên, thay vì cập nhật toàn bộ hàng tỷ trọng số truyền thống

1. LoRA và QLoRA khác với phương pháp fine-tuning truyền thống như thế nào?

Các mô hình ngôn ngữ lớn (LLM) là những hệ thống phức tạp bao gồm hàng tỷ tham số. Mỗi tham số đóng vai trò lưu trữ thông tin mà mô hình học được từ dữ liệu đầu vào. Càng nhiều tham số, mô hình càng có khả năng xử lý và biểu đạt thông tin ở cấp độ cao hơn – nhưng cũng đồng nghĩa với yêu cầu bộ nhớ và tài nguyên tính toán lớn hơn.

Phương pháp fine-tuning truyền thống thường yêu cầu điều chỉnh lại toàn bộ tham số trong mô hình. Với các LLM quy mô lớn, điều này đồng nghĩa với việc phải tối ưu hàng tỷ giá trị, tiêu tốn đáng kể thời gian và chi phí xử lý.

Một hệ quả tiêu cực dễ gặp phải trong quá trình này là overfitting – tình trạng mô hình học quá mức vào những chi tiết không quan trọng (hay còn gọi là “nhiễu”), làm giảm khả năng tổng quát hóa trên dữ liệu thực tế.

Bên cạnh nguy cơ overfitting, việc tinh chỉnh toàn bộ mô hình còn đi kèm chi phí tài nguyên rất lớn – điều mà không phải tổ chức nào cũng có khả năng đáp ứng.

LoRA và QLoRA ra đời như giải pháp fine-tuning hiệu quả hơn, giúp rút ngắn quá trình điều chỉnh mô hình mà vẫn giữ được độ chính xác. Thay vì cập nhật tất cả tham số, hai kỹ thuật này chỉ tập trung điều chỉnh những ma trận nhỏ nằm bên trong mô hình – giúp tiếp thu kiến thức mới mà không làm ảnh hưởng đến các năng lực đã có trước đó.

2. Cơ chế hoạt động của LoRA

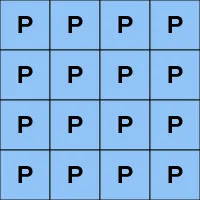

Thay vì tinh chỉnh toàn bộ mô hình LLM với hàng tỷ trọng số như trong fine-tuning truyền thống, kỹ thuật LoRA chỉ huấn luyện một phần nhỏ – chính xác là các ma trận có thứ hạng thấp (low-rank matrices), được thêm vào mô hình gốc.

Cụ thể, trong LoRA, toàn bộ trọng số ban đầu của mô hình sẽ được “đóng băng”, không thay đổi. Thay vào đó, hệ thống sẽ tạo ra các ma trận bổ sung nhỏ gọn, có ít tham số hơn – gọi là ma trận low-rank – để học thông tin mới. Những ma trận này thường chỉ chiếm một phần nhỏ như một hàng hoặc một cột trong toàn bộ cấu trúc tham số.

Sau khi quá trình huấn luyện kết thúc, các ma trận low-rank này sẽ được kết hợp vào mô hình chính. Việc tích hợp này cho phép mô hình áp dụng những gì đã học mà không cần thay đổi hay ghi đè toàn bộ cấu trúc gốc. Kết quả là:

– Tiết kiệm đáng kể tài nguyên

– Rút ngắn thời gian huấn luyện

– Hạn chế tối đa nguy cơ overfitting

Ví dụ dễ hình dung: nếu coi mô hình gốc là một bảng lớn gồm hàng ngàn ô dữ liệu, thì LoRA chỉ thêm một vài dòng dữ liệu nhỏ vào, đủ để “ghi nhớ” kiến thức mới, mà không phải viết lại toàn bộ bảng từ đầu.

3. Cải tiến với QLoRA

QLoRA là phiên bản nâng cấp của kỹ thuật LoRA, với ưu điểm vượt trội: tiết kiệm bộ nhớ hơn nữa.

Chữ “Q” trong QLoRA viết tắt cho “Quantized” – nghĩa là lượng tử hóa. Trong ngữ cảnh này, mô hình được nén bằng cách chuyển đổi các tham số chính xác cao (nhiều chữ số thập phân, tốn bộ nhớ) thành các tham số đơn giản hơn, kích thước nhỏ hơn nhưng vẫn giữ lại được phần lớn thông tin cốt lõi.

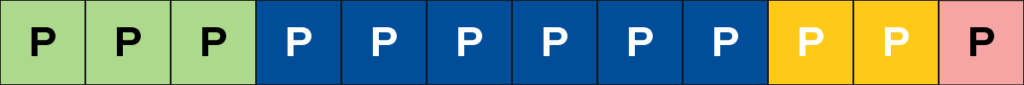

QLoRA sử dụng một định dạng dữ liệu mới gọi là 4-bit NormalFloat (NF4), giúp giảm kích thước lưu trữ của các ma trận đến 4 lần so với bản gốc, từ đó cho phép tinh chỉnh mô hình trên chỉ 1 GPU duy nhất – một lợi thế cực kỳ quan trọng với các nhóm có tài nguyên giới hạn.

Giả sử mô hình ban đầu có 12 tham số màu sắc đa dạng (đại diện cho mức độ chi tiết cao). Sau khi lượng tử hóa, chỉ còn lại 4 tham số đại diện, một số chi tiết nhỏ (như màu hồng) có thể bị mất do không đủ trọng số. Đây là cái giá đánh đổi giữa độ chính xác và dung lượng bộ nhớ.

Tuy nhiên, mục tiêu của QLoRA là sau khi huấn luyện các ma trận nhỏ này, chúng có thể kết hợp lại với mô hình gốc để giữ được tính chính xác cao nhất có thể, mà vẫn sử dụng ít tài nguyên hơn rất nhiều so với fine-tuning truyền thống.

Lợi ích nổi bật:

– Giảm mạnh chi phí bộ nhớ và tính toán

– Huấn luyện trên phần cứng giới hạn

– Duy trì hiệu năng và độ chính xác cao

– Phù hợp cho việc tinh chỉnh LLMs quy mô lớn trong môi trường hạn chế

4. Sự khác biệt giữa LoRA và QLoRA là gì?

LoRA là một kỹ thuật fine-tuning độc lập, giúp giảm chi phí huấn luyện bằng cách chỉ cập nhật một phần nhỏ các tham số thay vì toàn bộ mô hình.

Trong khi đó, QLoRA mở rộng từ LoRA, kết hợp thêm bước lượng tử hóa (quantization) để tối ưu hóa hơn nữa về bộ nhớ. QLoRA sử dụng các định dạng số lượng tử như NF4 để nén mô hình, giúp giảm đáng kể yêu cầu lưu trữ mà vẫn giữ được hiệu suất tốt.

Nên chọn kỹ thuật nào?

Việc lựa chọn giữa LoRA và QLoRA phụ thuộc vào nguồn lực tính toán và lưu trữ của bạn:

Nếu bạn có tài nguyên vừa đủ và muốn tinh chỉnh mô hình hiệu quả → LoRA là lựa chọn hợp lý.

Nếu bạn gặp giới hạn về GPU hoặc bộ nhớ → QLoRA sẽ tối ưu hơn, nhờ khả năng tiết kiệm tài nguyên đáng kể mà vẫn đảm bảo chất lượng đầu ra.